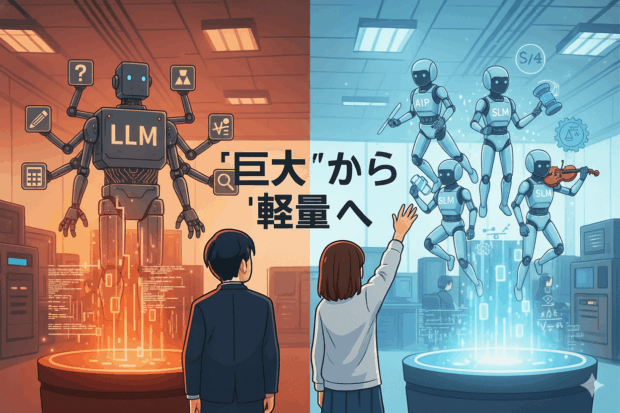

GPTやGeminiに代表される「大規模言語モデル(Large Language Model:LLM)」が社会的な注目を浴びてから、AIの発展は「モデルをどれだけ大きくできるか」という規模競争の様相を呈してきた。

だが、ここにきてその流れに変化が生まれている。

いま注目を集めているのは、むしろ小さく、軽く、効率的なAI──小規模言語モデル(Small Language Model:SLM)である。

なぜAIは“巨大化”から“軽量化”へと向かっているのか。その背景とメリット、そして代表的なモデルを見ていこう。

GPT、Claude、Geminiといった言語モデルの大規模化は、確かにAIの能力を飛躍的に高めた。

数千億~数兆パラメータ規模のモデルは、高度な言語理解・推論・生成を実現し、人間の知的作業の多くを支援できるようになった。

しかし、その裏側にはいくつもの課題がある。

まず計算コストの増大。大規模モデルのトレーニングには膨大なGPUリソースと電力が必要であり、研究者や中小企業が独自に開発・運用することはほぼ不可能である。

さらに、モデルサイズと性能向上が比例しないという問題も顕在化してきた。

一桁大きいモデルを作っても、性能はわずか数%しか上がらない──そんな“飽和点”が見えつつある。

このような状況の中で登場したのが、小規模言語モデルだ。

SLMは、パラメータ数を抑えながらも、高品質なデータと最適化された学習手法を用いて、特定領域でLLMに匹敵する性能を実現する。

Microsoftの「Phi シリーズ」や、Mistral AIの「Mistral 7B」はその代表例であり、「小さくても賢いAI」が現実のものとなっている。

AI業界の潮流はいま、「巨大な頭脳を作る」競争から、「限られたリソースで賢く動く」競争へと転換しつつある。

小規模言語モデルの特徴は、単に“サイズが小さい”ことだけではない。

それによって得られる運用上の柔軟性と現実的なコスト感にこそ価値がある。

SLMはパラメータ数が少ないため、GPUやメモリ消費が抑えられ、推論速度も速い。

クラウドだけでなく、ノートPCやスマートフォン、エッジデバイス上でもリアルタイムに動作できる。

この軽快さは、AIをあらゆる場所に展開するうえで欠かせない要素となる。

データをクラウドに送らず、ローカルで処理できる点も重要だ。

たとえば社内情報を扱うAIチャットボットや、医療・教育現場のアプリケーションでは、外部通信を伴わない安全なモデルが求められる。

SLMはこのようなオンデバイスAIやプライベートAIの実現を支えている。

LLMが汎用性を重視するのに対し、SLMは特定分野に特化した調整がしやすい。

医療、法律、製造、教育など、限られた専門用語や文脈を扱うタスクに最適化することで、軽量ながら高い精度を発揮できる。

これらの分野では、LLMよりも軽量・省リソースなSLMの方が、実用上の要件を満たすケースが多い。

| モデル名 | 提供企業/開発元 | パラメータ規模 | 特徴 |

|---|---|---|---|

| Phi-3 | Microsoft | 約3.8B~14B | 教師データの品質を高め、少ないパラメータでも高精度を実現。モバイル向け展開も視野。 |

| Mistral 7B | Mistral AI | 約7B | オープンソースで高性能。Llama 2 13Bに匹敵する精度を達成。 |

| Llama 3 8B | Meta | 約8B | 商用利用可のオープンモデル。拡張性が高く、研究・企業双方に普及。 |

| Gemma 2 2B / 9B | Google DeepMind | 2B / 9B | 学習効率と安全性を重視。小型ながら多言語処理に対応。 |

| TinyLlama | OSSコミュニティ | 約1.1B | 推論速度が非常に速く、教育・実験用として利用が広がる。 |

いずれのモデルも、従来のLLMに比べて1/10以下の規模でありながら、特定タスクでは同等の精度を発揮する。

その背景には、「知識蒸留(Knowledge Distillation)」や「モデル圧縮(Model Compression)」といった技術の進歩がある。

これらの手法により、巨大モデルで学んだ知識を小型モデルに移し替え、精度を保ったまま高速化を実現できるようになった。

AI開発の焦点は、もはや「パラメータの増加」ではなく「最適化」へと移りつつある。

生成AIの価値は、モデルのサイズではなく、どれだけ環境に適応できるか・どれだけ効率的に応答できるかで測られる時代に入った。

また、オープンソース化が進み、SLMは一般ユーザーでも手軽に扱える存在になりつつある。

Google Colabやローカル環境で動かせる軽量モデルの登場は、AIの民主化をさらに加速させている。

今後は、クラウドの大規模モデルとローカルの小規模モデルが共存するハイブリッド構成が一般化するだろう。

たとえば、オンデバイスのSLMが即時応答を担い、クラウド上のLLMが高度な推論を補完する――そんな役割分担が現実味を帯びている。

小規模言語モデルは、AIの新たな地平を切り拓く存在である。

それは“巨大な知能”の縮小版ではなく、「必要な賢さを、必要な場所に」届けるための次世代AIの形だ。